di Rodolfo Marchisio

Mentre continua il marketing e l’offerta di corsi, libri, incontri sull’uso della IA nella scuola, per fortuna più alle superiori, ma sta arrivando, perché è la moda dell’anno, lasciano perplesse le modalità di questa iniezione di tecnologia, teoricamente avanzata, ma sempre in corso di approfondimento e discussione tra gli esperti; anche presunti. Dite un nome di uno che si occupi o si sia occupato della scuola e verificate se non ha già detto la sua.

Negli USA la sperimentazione nelle scuole pone diversi interrogativi simili a quelli del nostro PNRR.

Uso contro cultura.

Il problema di partenza è la modalità con cui viene proposta alla scuola. Come ogni tecnologia, insegnando (a docenti ed allievi) ad usare. Cosa fa e come si usa. Non cosa ci sta dietro, quali conseguenze può avere su di noi e sui nostri allievi, come stiamo cambiando nella relazione con le tecnologie. Domande che ci dovremmo porre per capire.

Questo per un difetto congenito nel rapporto tecnologia/scuola e per una mancanza di chiarezza da parte delle Istituzioni. Sembra che nella vita dei nostri allievi sarà più importante saper usare che capire un po’ di più le tecnologie che già usano e che useranno sempre più. E che li stanno cambiando.

Competenza digitale. Una delle competenze chiave per l’apprendimento permanente

“La competenza digitale implica l’uso sicuro, critico e responsabile delle tecnologie digitali e il loro impiego nell’apprendimento, nel lavoro e nella partecipazione alla società̀. Comprende l’alfabetizzazione all’informazione e ai dati, la comunicazione e la collaborazione, l’alfabetizzazione ai media, la creazione di contenuti digitali (compresa la programmazione), la sicurezza (compreso il benessere digitale e le competenze relative alla sicurezza informatica), le questioni relative alla proprietà̀ intellettuale, la risoluzione di problemi e il pensiero critico.” [1]

Continua a leggere

di Rodolfo Marchisio

Mentre continua il marketing e l’offerta di corsi, libri, incontri sull’uso della IA nella scuola, per fortuna più alle superiori, ma sta arrivando, perché è la moda dell’anno, lasciano perplesse le modalità di questa iniezione di tecnologia, teoricamente avanzata, ma sempre in corso di approfondimento e discussione tra gli esperti; anche presunti. Dite un nome di uno che si occupi o si sia occupato della scuola e verificate se non ha già detto la sua.

Negli USA la sperimentazione nelle scuole pone diversi interrogativi simili a quelli del nostro PNRR.

Uso contro cultura.

Il problema di partenza è la modalità con cui viene proposta alla scuola. Come ogni tecnologia, insegnando (a docenti ed allievi) ad usare. Cosa fa e come si usa. Non cosa ci sta dietro, quali conseguenze può avere su di noi e sui nostri allievi, come stiamo cambiando nella relazione con le tecnologie. Domande che ci dovremmo porre per capire.

Questo per un difetto congenito nel rapporto tecnologia/scuola e per una mancanza di chiarezza da parte delle Istituzioni. Sembra che nella vita dei nostri allievi sarà più importante saper usare che capire un po’ di più le tecnologie che già usano e che useranno sempre più. E che li stanno cambiando.

Competenza digitale. Una delle competenze chiave per l’apprendimento permanente

“La competenza digitale implica l’uso sicuro, critico e responsabile delle tecnologie digitali e il loro impiego nell’apprendimento, nel lavoro e nella partecipazione alla società̀. Comprende l’alfabetizzazione all’informazione e ai dati, la comunicazione e la collaborazione, l’alfabetizzazione ai media, la creazione di contenuti digitali (compresa la programmazione), la sicurezza (compreso il benessere digitale e le competenze relative alla sicurezza informatica), le questioni relative alla proprietà̀ intellettuale, la risoluzione di problemi e il pensiero critico.” [1]

Continua a leggere

![]()

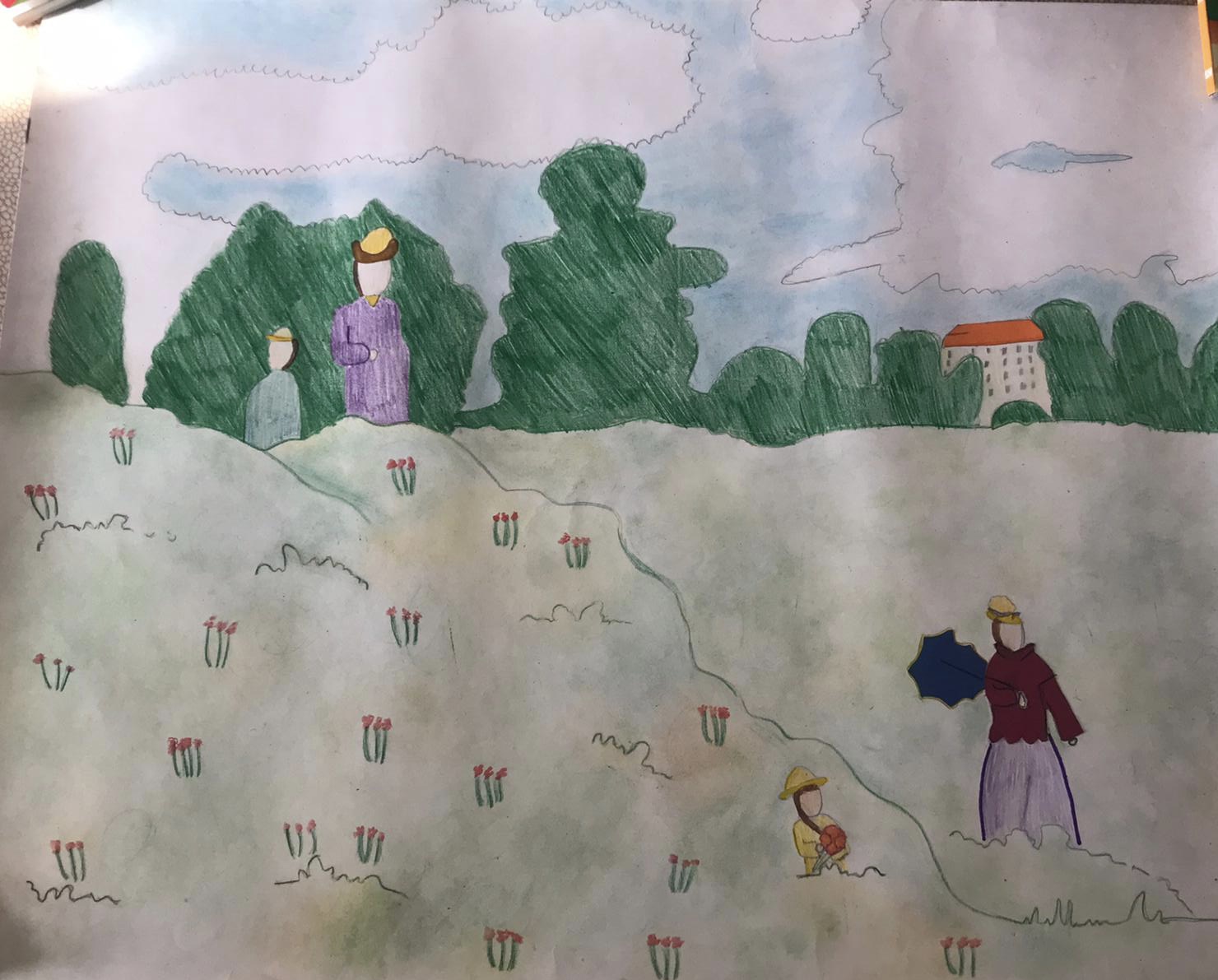

disegno di Matilde Gallo, anni 10[/caption]

di Rodolfo Marchisio

Io questo pezzo non lo volevo scrivere, perché penso che rispondere a EGdL (quello della “predella per ristabilire autorità del docente”, confondendo autorità con autorevolezza), che non è un esperto di scuola, sia quello che lui cercava, una provocazione per far parlare di sé. Ma invitato e tirato per i capelli da un paio di considerazioni, cerco di essere breve.

disegno di Matilde Gallo, anni 10[/caption]

di Rodolfo Marchisio

Io questo pezzo non lo volevo scrivere, perché penso che rispondere a EGdL (quello della “predella per ristabilire autorità del docente”, confondendo autorità con autorevolezza), che non è un esperto di scuola, sia quello che lui cercava, una provocazione per far parlare di sé. Ma invitato e tirato per i capelli da un paio di considerazioni, cerco di essere breve.