di Marco Guastavigna Ammesso che a 72 anni ci si possa definire esperto di qualcosa, sono arrivato a individuare il mio campo da poche ore: è la logistica digitale della conoscenza, con una particolare attenzione all’istruzione. https://vimeo.com/1001560159 Questa pomposa etichetta ha almeno un pregio: riporta “digitale” al suo ruolo politico-grammaticale di aggettivo. Per troppo tempo, infatti, è stato un sostantivo, “il digitale”, primigenio esempio di concetto intenzionalmente tenuto nello stato di nebulosità. A condividere questa condizione di formulazione utile a contenere il pacchetto operativo, cognitivo e culturale del momento è arrivata da circa due anni l’intelligenza artificiale, espressione che in quasi 70 anni di vita ha a sua volta assunto significati e adottato paradigmi molto diversi gli uni dagli altri. Aumentando così il tasso di confusione, superficialità, pressapochismo, massimi-sistemismo di una discussione pubblica sempre più tossica, perché inutilmente polarizzata tra l’impreparazione degli apocalittici e quella degli integrati di turno. Continua a leggere

![]()

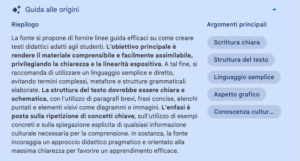

Immagine realizzata con Copilot Pro[/caption]

di Marco Guastavigna

Proponiamo un’attività davvero straordinaria, visti i tempi: formarsi un’opinione propria.

Come? Questo articolo incorpora il file di un documento ufficiale (“Strategia italiana per l’intelligenza artificiale”)

[dearpdf id=”4974″][/dearpdf]

e – separatamente – un altro, contenente le sintesi del documento stesso ad opera di:

Immagine realizzata con Copilot Pro[/caption]

di Marco Guastavigna

Proponiamo un’attività davvero straordinaria, visti i tempi: formarsi un’opinione propria.

Come? Questo articolo incorpora il file di un documento ufficiale (“Strategia italiana per l’intelligenza artificiale”)

[dearpdf id=”4974″][/dearpdf]

e – separatamente – un altro, contenente le sintesi del documento stesso ad opera di:

Immagine realizzata con Copilot Pro[/caption]

di Marco Guastavigna

Non credevo alle mie orecchie quando ho avuto notizia di questa consegna di lavoro, assegnata in una prima classe di secondaria di primo grado: “Scrivi un testo descrittivo sul tuo quaderno e poi ricopialo con Google documenti”.

Eppure era proprio così!

Ora, al di là del fatto che il correttore ortografico del dispositivo segnala “ricopialo” come ortograficamente errato, questo approccio è indicativo di una delle molte catastrofi culturali verificatesi sotto l’egida dell’innovazione digitale.

Già, perché il tutto è rubricato come “informatica”.

Questa dicitura richiama, a chi ha vissuto tutte le diverse retoriche innovative – dall’ingresso trionfale nelle aule dei Commodore 64 al respingimento degli smartphone – una visione assai diffusa negli anni ‘80: l’informatica (intesa come epopea della programmazione) era infatti considerata il nuovo latino (ovvero le si assegnava valenza sintattica e logica universale) e quindi era necessario studiare e diffondere il

Immagine realizzata con Copilot Pro[/caption]

di Marco Guastavigna

Non credevo alle mie orecchie quando ho avuto notizia di questa consegna di lavoro, assegnata in una prima classe di secondaria di primo grado: “Scrivi un testo descrittivo sul tuo quaderno e poi ricopialo con Google documenti”.

Eppure era proprio così!

Ora, al di là del fatto che il correttore ortografico del dispositivo segnala “ricopialo” come ortograficamente errato, questo approccio è indicativo di una delle molte catastrofi culturali verificatesi sotto l’egida dell’innovazione digitale.

Già, perché il tutto è rubricato come “informatica”.

Questa dicitura richiama, a chi ha vissuto tutte le diverse retoriche innovative – dall’ingresso trionfale nelle aule dei Commodore 64 al respingimento degli smartphone – una visione assai diffusa negli anni ‘80: l’informatica (intesa come epopea della programmazione) era infatti considerata il nuovo latino (ovvero le si assegnava valenza sintattica e logica universale) e quindi era necessario studiare e diffondere il